Towards End-to-End Optimization of LLM-based Applications with Ayo

基本信息

| 属性 | 内容 |

|---|---|

| 标题 | Towards End-to-End Optimization of LLM-based Applications with Ayo |

| 作者 | Xin Tan, Yinmin Jiang, Yitao Yang, Hong Xu |

| 机构 | The Chinese University of Hong Kong |

| 会议 | ASPLOS 2025 (ACM International Conference on Architectural Support for Programming Languages and Operating Systems) |

| 总结 | 用"原语拆分并优化以生成运行图"以及“上下层联合的运行时调度”实现LLM 应用工作流的端到端加速 |

摘要

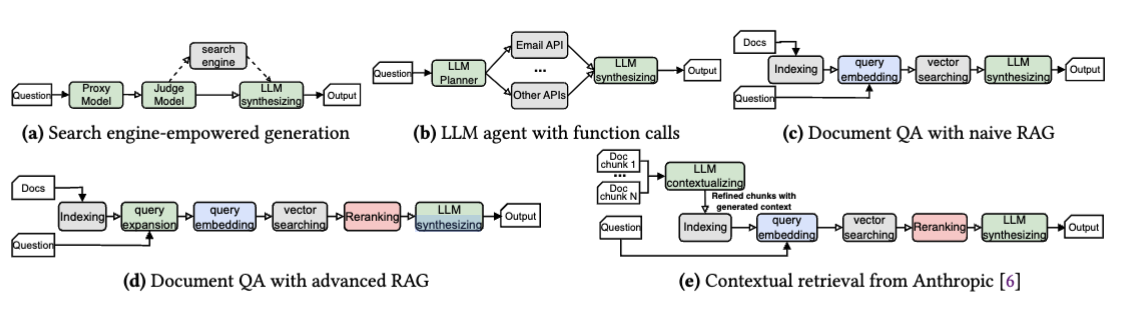

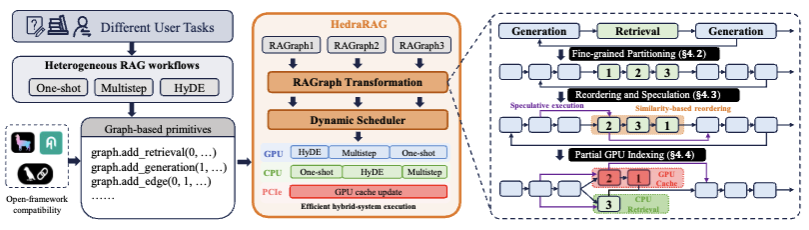

基于大语言模型(LLM)的应用由 LLM 组件和非 LLM 组件共同组成,每一部分都会增加端到端的延迟。尽管在优化 LLM 推理方面已经做出了巨大努力,但端到端的工作流优化却一直被忽视。现有的框架采用基于任务模块的粗粒度编排,这种方式将优化限制在每个模块内部,导致了次优的调度决策。

我们提出了一种细粒度的端到端编排方法,它利用 任务原语(task primitives) 作为基本单元,并将每个查询的工作流表示为一个原语级的数据流图。这种方法显式地暴露了更大的设计空间,使得跨越不同模块原语的并行化和流水线优化成为可能,并增强了调度能力以提升应用级的性能。我们构建了 Ayo,这是一个实现了该方案的新型 LLM 应用编排框架。全面的实验表明,在各种流行的 LLM 应用中,Ayo 相比现有系统能够实现高达 2.09 倍的加速比。